2017-05-31

13:04:56

2017-05-31

13:04:56

3674

阅读

3674

阅读

2017年5月30日—NVIDIA公司宣布同全球领先的原始设计制造商(ODM)-富士康(Foxconn)、英业达(Inventec)、广达电脑(Quanta)与纬创(Wistron)开展合作,以期更加快速地满足市场对AI云计算的需求。

通过NVIDIAHGX合作伙伴计划,NVIDIA将让每家ODM尽早访问NVIDIAHGX参考架构,NVIDIAGPU计算技术以及设计指南。微软ProjectOlympus计划、Facebook的BigBasin系统与NVIDIADGX-1人工智能超级计算机也均使用了HGX数据中心设计方案。

通过将HGX用作起始秘方,ODM合作伙伴可以与NVIDIA一起更加快速地为超大型数据中心设计并推出一系列合格且经过GPU加速的系统。通过该计划,NVIDIA工程师将与ODM密切合作,以减少从设计到生产部署的时间。

在过去的1年里,对于人工智能计算资源的总体需求急剧增长,而市场对于NVIDIAGPU计算平台的采用及性能需求也随之增加。今天,全球前10家超大规模企业均在其数据中心内使用NVIDIAGPU加速器。

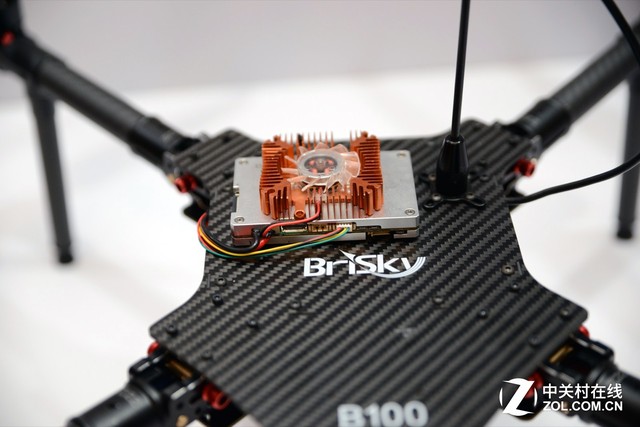

凭借新的基于NVIDIAVolta的GPU所提供的比上一代GPU三倍的性能,ODM可以根据比较新的NVIDIA技术为市场需求提供比较新产品。

NVIDIA加速计算业务部总经理IanBuck表示:“加速计算正在飞速发展–在仅仅1年之内,我们便使得TeslaGPU深度学习性能提升了3倍–这对系统设计方式产生了显著影响。通过我们的HGX合作伙伴计划,设备制造商可以确保其向不断扩大的云计算提供商提供比较新的AI技术。”

灵活、可升级的设计

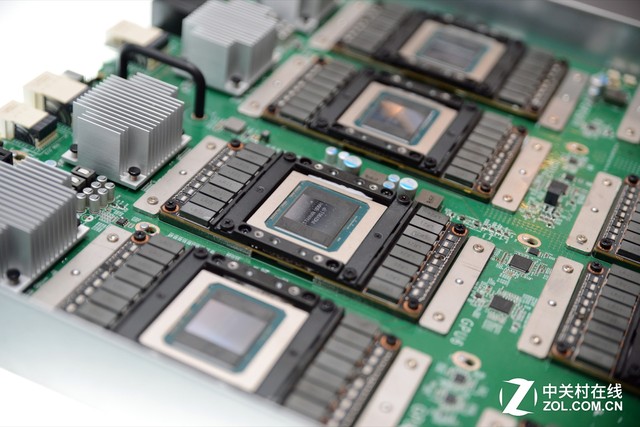

为了满足超大规模云环境所独有的高性能、高效率和大规模扩展需求,NVIDIA构建了HGX参考设计。由于可以根据工作负载需求进行高度配置,HGX能够以多种方式轻松融合GPU与CPU,进而用于高性能计算、深度学习训练与深度学习推理。

标准的HGX设计架构包含8颗SXM2尺寸的NVIDIATeslaGPU加速器,并采用NVIDIANVLink高速互连技术与经过优化的PCIe拓扑并以多维数据集网格连接。借助模块化设计,HGX机箱适用于全球现有数据中心机架部署,并酌情使用超大规模CPU节点。

NVIDIATeslaP100与V100GPU加速器均兼容于HGX。今年底,在V100GPU上市后,这可以让基于HGX的所有产品实现即时升级。

对于想要托管全新NVIDIAGPUCloud平台的云提供商而言,HGX堪称理想的参考架构。NVIDIAGPUCloud管理着一系列完整集成且经过优化的深度学习框架容器的目录,包括Caffe2、CognitiveToolkit、MXNet与TensorFlow。

富士康/鸿海精密工业股份有限公司总经理兼鸿佰科技股份有限公司(IngrasysTechnologyInc.)总裁TaiyuChou表示:“通过与NVIDIA的这一全新合作伙伴计划,我们将能够更加快速地满足我们客户不断增加的需求,其中部分客户管理着一些全球比较大型的数据中心。尽早获得NVIDIAGPU技术与设计指南,将有助于我们更加快速地推出创新型产品,充分满足我们客户不断增长的人工智能计算需求。”

英业达集团IECChina业务主管EvanChien表示:“与NVIDIA开展更加密切的合作,将有助于我们为全球数据中心基础架构注入更高水平的创新。通过我们的紧密协作,我们将能够更加有效地满足管理超大规模云环境公司的计算密集型人工智能需求。”

广达电脑高级副总裁兼云达科技(QCT)总裁MikeYang表示:“借助NVIDIA的人工智能计算专长,我们将能够立即向市场推出变革性的解决方案,满足人工智能时代的新计算需求。”

纬创首席技术官兼企业业务组总裁DonaldHwang表示:“作为NVIDIA的长期合作伙伴,我们期待着深化我们之间的关系,以便我们能够满足超大规模数据中心客户日益增长的计算需求。我们的客户渴望获得更高的GPU计算力量,以处理各种人工智能工作负载,而通过这一全新合作,我们将能够更快速地提供新的解决方案。”

微软AzureHardwareInfrastructure总经理兼杰出工程师KushagraVaid表示:“我们与鸿佰科技及NVIDIA合作开创了全新行业标准设计,以满足人工智能新时代日益增长的需求。HGX-1人工智能加速器是作为微软ProjectOlympus的一部分而开发的,以便通过为多达32颗GPU选用高带宽互联性而实现极高的性能可扩展性。”